Anuncios

¿Te has parado a pensar alguna vez en los riesgos de la tecnología y en cuánto confiamos en la inteligencia artificial sin cuestionarla?

Desde recomendaciones de películas y música hasta decisiones más importantes como diagnósticos médicos, análisis de crédito e incluso sentencias judiciales, la IA ya está moldeando nuestras vidas, a menudo sin que nos demos cuenta. Pero ¿y si estos sistemas, en lugar de ayudar, están empeorando los problemas?

La IA promete eficiencia, precisión e imparcialidad. Sin embargo, la realidad puede ser muy distinta. Al entrenarse con datos sesgados, la IA puede discriminar, difundir desinformación y reforzar las desigualdades.

Peor aún, estos fallos no son sólo errores técnicos sino el resultado de un desarrollo apresurado, a menudo sin una regulación adecuada.

El problema no es la IA en sí, sino cómo se desarrolla y utiliza. Si no nos detenemos a reflexionar ahora, podríamos estar creando una tecnología que, en lugar de resolver los desafíos, solo los amplifique.

El rápido crecimiento de la IA y los riesgos tecnológicos

En los últimos años, la inteligencia artificial ha evolucionado desde una herramienta confinada a los laboratorios de investigación a una parte integral de la economía global.

Se están aplicando modelos avanzados en sectores como la salud, la seguridad, las finanzas y las comunicaciones, desempeñando un papel crucial en la toma de decisiones cruciales. Sin embargo, esta rápida expansión también plantea serias preocupaciones.

Steven Adler, ex investigador de seguridad de OpenAI, sostiene que la IA está creciendo sin las precauciones adecuadas y que su aplicación sin restricciones podría tener consecuencias impredecibles.

Empresas como OpenAI, Google y DeepSeek están a la vanguardia de esta revolución, pero el rápido ritmo de la innovación a menudo supera la capacidad de supervisión y regulación para mantenerse al día.

Para seguir de cerca los impactos y desafíos de la inteligencia artificial, consulte la cobertura completa aquí:

Riesgos clave de la rápida expansión de la IA:

- Difusión de desinformación: Modelos como DeepSeek pueden crear contenido falso muy convincente, lo que hace más difícil distinguir entre hechos y manipulación.

- Sesgo algorítmico: Cuando se entrena con datos sesgados, la IA puede reforzar los prejuicios existentes, perpetuando las desigualdades en áreas como el crédito, la seguridad y la contratación.

- Falta de regulación: La ausencia de directrices claras permite a las empresas desarrollar e implementar tecnologías sin responsabilizarse de sus impactos sociales y éticos.

- Uso malicioso de la IA: Las empresas ya están explotando herramientas basadas en IA para el fraude digital, las falsificaciones profundas y la manipulación política, lo que aumenta los desafíos de ciberseguridad.

Dados estos riesgos, es crucial analizar cómo puede fallar la IA y cuáles pueden ser las consecuencias de estos fallos.

Evaluación de riesgos en sistemas de inteligencia artificial

No todos los sistemas de IA presentan el mismo nivel de riesgo. Algunas aplicaciones, como los asistentes virtuales y los sistemas de recomendación, tienen un impacto relativamente bajo.

Otros, como los diagnósticos médicos automatizados y los algoritmos de aprobación de crédito, pueden tener graves consecuencias si fallan. Entonces, ¿cómo podemos medir el riesgo de un sistema de IA?

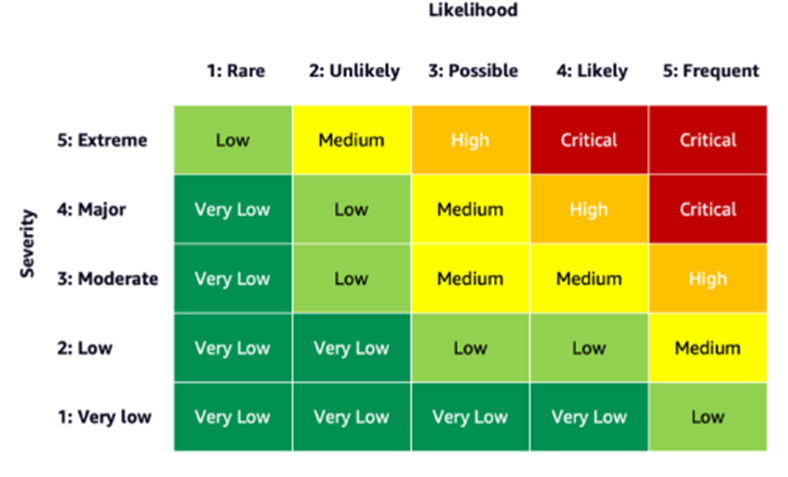

El blog de AWS presenta un enfoque estructurado para este análisis, proponiendo una Matriz de Riesgos para Sistemas de IA, que clasifica los riesgos en función de dos factores principales: probabilidad de falla e impacto de esa falla.

Esta matriz ayuda a las empresas y desarrolladores a identificar qué modelos requieren más supervisión, auditoría y regulación antes de implementarse, minimizando los riesgos de la tecnología en las aplicaciones de IA.

Matriz de riesgos de IA: clasificación e impacto

La siguiente imagen ilustra cómo se pueden clasificar los diferentes sistemas de IA en función de sus riesgos.

Los modelos con alta probabilidad de error y alto impacto, como los que se usan en atención médica y justicia penal, requieren una supervisión y pruebas rigurosas antes de su implementación a gran escala.

Por otro lado, los sistemas con bajo impacto y baja probabilidad de error pueden someterse a un proceso de validación más flexible.

La categorización presentada por AWS resalta la importancia de un enfoque equilibrado: regular excesivamente los sistemas de bajo riesgo puede limitar la innovación, mientras que no regular los modelos de alto riesgo puede tener graves consecuencias para los individuos y la sociedad.

La inteligencia artificial requiere una evaluación continua

La IA no es estática: evoluciona constantemente, al igual que los riesgos de la tecnología. Como muestra la matriz de AWS, la evaluación de riesgos no debe ser un proceso puntual, sino una práctica continua.

Las empresas, los desarrolladores y los reguladores deben adoptar esta mentalidad para garantizar que desarrollan y utilizan la IA de forma segura y ética.

Esto requiere no sólo pruebas rigurosas antes de su implementación, sino también seguimiento y ajustes continuos a medida que la tecnología se expande a nuevas áreas de la sociedad.

Al mantener un proceso de evaluación continuo, podemos garantizar que la IA sirva a la humanidad de manera responsable y no se convierta en una fuente de daño o desigualdad.

Fallos tecnológicos: cuando la inteligencia artificial comete errores y amplifica los problemas

Aunque los sistemas de inteligencia artificial están diseñados para optimizar procesos y ofrecer soluciones innovadoras, en la realidad pueden cometer errores importantes.

Muchos de estos fallos se deben a problemas estructurales en los datos utilizados para entrenar los modelos, así como a la falta de una supervisión adecuada.

Ejemplos de fallos de la IA:

La inteligencia artificial de Amazon y la discriminación de género

Amazon desarrolló un sistema de reclutamiento basado en inteligencia artificial, pero pruebas internas revelaron que el modelo discriminaba a las mujeres.

La IA entrenada con datos históricos de contratación, que eran predominantemente masculinos, favoreció los currículos masculinos y penalizó a los candidatos femeninos.

El proyecto finalmente fue descartado, pero expuso un problema crítico: los algoritmos pueden aprender y reforzar sesgos en lugar de corregirlos.

IA en la justicia: Sentencias más severas para los acusados negros

En Estados Unidos se utilizó un software llamado COMPAS para predecir la probabilidad de reincidencia delictiva.

El sistema exhibió sesgo racial, clasificando a los acusados negros como más propensos a reincidir en comparación con los acusados blancos, incluso cuando las circunstancias eran similares.

Esta distorsión condujo a sentencias más severas para ciertos grupos, lo que exacerbó las desigualdades dentro del sistema de justicia penal.

Para una visión más profunda sobre cómo la IA puede reforzar y combatir los sesgos, consulte el artículo completo aquí:

DeepSeek y la propagación de noticias falsas

The Guardian informó que DeepSeek, una IA desarrollada en China, podría explotar la desinformación a gran escala. Con un alto nivel de sofisticación, el sistema puede manipular elecciones, difundir propaganda política y generar desinformación geopolítica.

La falta de transparencia en el funcionamiento y la capacitación del modelo genera preocupaciones sobre su impacto en la democracia y la confianza pública en la información digital.

Estos ejemplos demuestran que la IA no sólo comete errores, sino que también puede amplificar problemas preexistentes, empeorando las injusticias y convirtiéndose en una amenaza para la sociedad.

¿Es suficiente la autorregulación de las empresas de IA?

Ante los desafíos que plantea la inteligencia artificial, surge una pregunta fundamental: ¿pueden las empresas tecnológicas autorregularse y garantizar que sus sistemas sean seguros y éticos?

Según un informe de Forbes, la experiencia demuestra que la autorregulación no es efectiva. Las empresas tecnológicas suelen priorizar el desarrollo de productos innovadores y rentables, relegando la seguridad y las preocupaciones éticas a un segundo plano.

Problemas con la autorregulación de la industria de la IA:

- Falta de transparencia: Las empresas a menudo no revelan detalles sobre fallas o sesgos algorítmicos.

- Incompatibilidad: La implementación de controles de seguridad puede retrasar el desarrollo y reducir las ganancias corporativas.

- Falta de supervisión externa: Sin regulación gubernamental, las prácticas de las empresas quedan sin control.

Por ejemplo, OpenAI ha recibido críticas de exempleados que advirtieron que la empresa priorizaba el crecimiento sobre la seguridad. En algunos casos, estas advertencias fueron ignoradas, lo que demuestra que basarse únicamente en la ética corporativa puede ser una estrategia de alto riesgo.

¿Cómo reducir los riesgos de la tecnología en IA?

La inteligencia artificial ya forma parte de nuestra vida diaria y su influencia seguirá creciendo. Por lo tanto, la pregunta central no es si deberíamos usarla, sino cómo podemos garantizar su uso responsable y beneficioso.

Medidas esenciales para minimizar los riesgos de la tecnología en IA:

- Regulación global: Se deben establecer leyes y directrices para garantizar el desarrollo seguro de la IA.

- Auditorías independientes: Se debería exigir a las empresas que sometan sus modelos a revisiones externas para identificar sesgos y fallas.

- Mayor transparencia: Las organizaciones necesitan revelar datos sobre errores, sesgos algorítmicos y acciones correctivas adoptadas.

- Inversión en IA responsable: La investigación debería centrarse en hacer que la inteligencia artificial sea más ética, segura e imparcial.

Estas acciones son esenciales para garantizar que la IA contribuya al progreso social sin amplificar los problemas existentes.

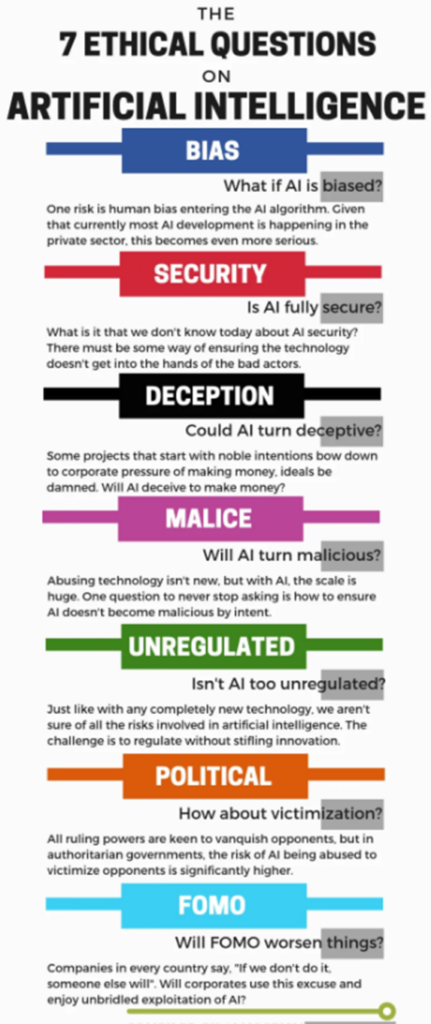

Los riesgos éticos de la IA: una visión general

El avance de la inteligencia artificial trae consigo beneficios innegables, pero también plantea dilemas éticos que no pueden ignorarse.

Cuestiones como la privacidad, la discriminación algorítmica, la manipulación de la información y los impactos en el mercado laboral ya figuran entre los desafíos que enfrentan las empresas, los gobiernos y la sociedad.

Para comprender mejor estos riesgos, la siguiente infografía presenta de forma clara y objetiva los principales desafíos éticos asociados al uso de IA.

Si analizamos estas cuestiones de forma estructurada, queda claro que es esencial un desarrollo tecnológico responsable.

La inteligencia artificial puede ser un aliado poderoso, pero sin regulación ni transparencia, su impacto puede ser perjudicial. Como sociedad, debemos garantizar que esta tecnología se utilice para impulsar el progreso en lugar de agravar las desigualdades y las amenazas a la democracia.

Necesitamos una IA confiable y segura para reducir los riesgos de la tecnología.

El avance de la inteligencia artificial presenta inmensas oportunidades pero también conlleva desafíos complejos.

Como lo demuestran casos como la inteligencia artificial de Amazon, el sistema COMPAS y DeepSeek, cuando se gestiona mal, esta tecnología puede amplificar las desigualdades, difundir información errónea y comprometer la seguridad digital.

Los expertos advierten que la regulación es esencial para evitar que las empresas implementen modelos de IA sin considerar sus implicaciones sociales y éticas.

Sin transparencia, supervisión y auditorías independientes, la inteligencia artificial podría convertirse más en una amenaza que en un beneficio.

La tecnología debe servir a la humanidad, no al revés. Si queremos un futuro seguro y justo, debemos actuar ahora.

Referencias

Forbes. (25 de enero de 2024). IA confiable: una serie de fallos de IA demuestran que la autorregulación no funciona. Forbes.

Forbes. (29 de abril de 2023). La inteligencia artificial puede amplificar los sesgos, pero también los combate. Forbes.

Inversor impulsado por datos (sin fecha). ¿Cuáles son los riesgos éticos que corremos con la IA? (Infografía) Medio.

AWS. (sin fecha). Aprenda a evaluar el riesgo de los sistemas de IA. Blog de aprendizaje automático de AWS.

The Guardian. (29 de enero de 2025). Los avances de DeepSeek podrían aumentar el riesgo de seguridad, afirma el "padrino" de la IA. El guardián.

The Guardian. (28 de enero de 2025). Los expertos instan a tener precaución con el uso de la inteligencia artificial china DeepSeek. El guardián.

The Guardian. (28 de enero de 2025). Un ex investigador de seguridad de OpenAI califica de "aterrador" el ritmo de desarrollo de la IA. El guardián.