Anuncios

¿Estamos prediciendo o prejuzgando?

Imagine este escenario: se utiliza un sistema de inteligencia artificial para predecir la próxima crisis económica o identificar las comunidades más afectadas por un desastre natural.

Suena fantástico, ¿verdad? Pero ¿qué pasa si estos sistemas terminan tomando decisiones basadas en sesgos históricos o reforzando estereotipos? ¿Y si, en lugar de ayudar, la tecnología exacerba las desigualdades?

Este es el debate central en torno al sesgo algorítmico, una preocupación creciente a medida que la IA se vuelve indispensable en diversos campos. Si bien se promueve ampliamente la idea de que la tecnología es imparcial, la realidad es que los algoritmos simplemente reproducen lo que aprenden, y a menudo aprenden de datos plagados de sesgos.

En este artículo, exploraremos cómo la inteligencia artificial puede perpetuar las desigualdades analizando casos reales, revisando estudios de expertos e investigando soluciones para garantizar que la IA sirva como una fuerza para el bien en lugar de otro engranaje en la rueda de las injusticias sociales.

La paradoja de la neutralidad en la inteligencia artificial

Vayamos directo al grano: la inteligencia artificial no es neutral. Los diseñadores construyen sistemas para procesar la información objetivamente, pero estos sistemas reflejan directamente los datos utilizados para entrenarlos.

Un análisis de Bloomberg destaca que los algoritmos inevitablemente presentan sesgos históricos. Los ingenieros no crean sesgos deliberadamente; las desigualdades provienen de los propios datos del mundo real.

Tomemos, por ejemplo, un sistema diseñado para predecir el impacto de un terremoto. Este sistema debe decidir dónde asignar recursos. Analizará datos históricos, pero si estos muestran que los barrios adinerados recibieron más ayuda en el pasado, el algoritmo podría simplemente "aprender" que estas áreas son más prioritarias, ignorando por completo a las comunidades vulnerables que anteriormente estaban desatendidas.

Lo fascinante aquí es cómo la tecnología resuelve problemas y los crea a la vez. Cuando se basa en una base de datos sólida y objetivos claros, la IA predice crisis eficazmente. De lo contrario, como demuestra la práctica, la IA simplemente perpetúa las desigualdades.

¿Quieres saber más sobre cómo la IA puede perpetuar las desigualdades? ¡Lee el artículo completo para descubrir las consecuencias y las posibles soluciones!

Estereotipos incrustados en algoritmos

Uno de los aspectos más preocupantes del sesgo algorítmico es cómo puede amplificar los estereotipos culturales y raciales, a veces de maneras casi invisibles. Por ejemplo, Con cable destacó cómo los sistemas de IA generativos, como los chatbots o los modelos de lenguaje, tienden a reproducir sesgos de género y raciales.

Esto sucede porque estas herramientas aprenden de grandes conjuntos de datos, muchos de los cuales están plagados de ejemplos de discriminación.

Un caso bien conocido es el uso de IA en la vigilancia predictiva. En este caso, el algoritmo analiza patrones delictivos e intenta anticipar dónde podrían ocurrir nuevos delitos.

¿El problema? Estos sistemas suelen recomendar un aumento del patrullaje en barrios predominantemente negros o de bajos ingresos. Esto no es casualidad; es un reflejo de los datos históricos sobre la actividad policial, que ya estaban sesgados.

Y hay más. Un estudio comentado por Forbes Se reveló que la IA, al predecir crisis o comportamientos, suele atribuir comportamientos negativos o de riesgo a ciertos grupos raciales o socioeconómicos. Esto no solo genera estigma, sino que también influye en políticas públicas que refuerzan ciclos de exclusión.

En definitiva, la IA no crea estos estereotipos desde cero; simplemente reproduce lo que los humanos han hecho en el pasado. Pero para muchos, esto agrava aún más el problema.

Después de todo, un algoritmo puede parecer imparcial, pero sus decisiones pueden afectar directa y desigualmente las vidas.

Cómo el sesgo algorítmico afecta la predicción de crisis

Seamos honestos: predecir crisis no es tarea fácil. Para ello, los sistemas de inteligencia artificial deben trabajar con datos históricos, muchos de los cuales no se recopilaron ni analizaron con la justicia social en mente. ¿El resultado? Predicciones sesgadas.

La Universidad Chapman destaca esta cuestión claramente: si un algoritmo se entrena con datos que descuidan a las minorías o a las comunidades marginadas, inevitablemente replicará esas deficiencias.

Tomemos, por ejemplo, un sistema diseñado para predecir qué regiones se verán más afectadas por una crisis de salud pública. Si los datos históricos muestran que las comunidades ricas recibieron mayor inversión en infraestructura sanitaria, el algoritmo podría pasar por alto las necesidades urgentes de las zonas desatendidas.

El problema aquí no es solo técnico, sino ético. ¿Nos sentimos realmente cómodos con la idea de que una historia de desigualdad deba dictar el futuro?

Obtenga más información sobre los desafíos éticos de la IA en la predicción de crisis.

Adopción de IA en las empresas: una cuestión de prioridades y riesgos

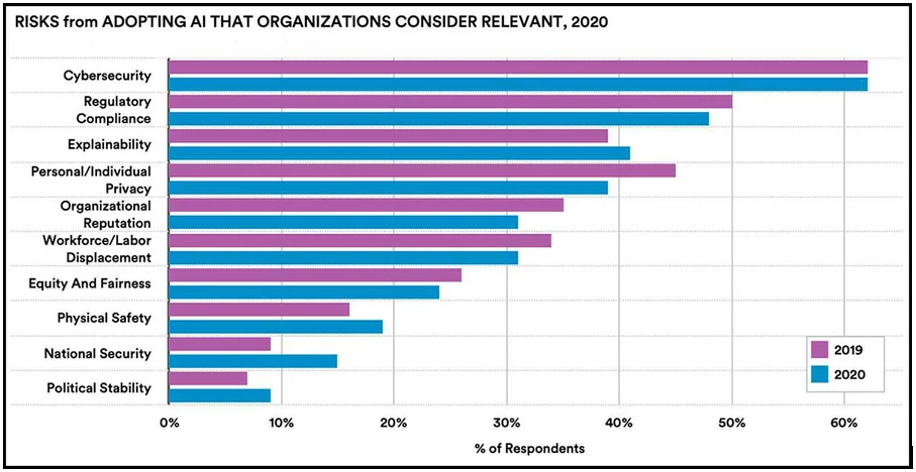

La inteligencia artificial se está adoptando ampliamente en sectores como las telecomunicaciones, los servicios financieros y la industria automotriz, pero esta expansión no siempre viene acompañada de una visión crítica de los riesgos involucrados.

El gráfico a continuación, basado en una encuesta de McKinsey, muestra que si bien la mayoría de las empresas reconocen preocupaciones como la ciberseguridad, cuestiones éticas como la privacidad y la equidad aún pasan en gran medida desapercibidas para la mayoría.

Estos datos resaltan una brecha importante entre la investigación académica, que ha estado debatiendo activamente temas como el sesgo algorítmico y la equidad de la IA, y las prácticas comerciales.

Si bien los investigadores colocan estas cuestiones en el primer plano de las discusiones, muchas corporaciones parecen carecer de una comprensión plena de los impactos éticos de la IA en sus operaciones.

¿Qué quiere decir esto? A pesar de la rápida adopción de la IA, todavía no hay urgencia en integrar consideraciones éticas y garantizar que estas tecnologías se utilicen de manera justa y responsable.

El béisbol y otras historias de sesgo algorítmico

¿Busca un ejemplo más inesperado pero igualmente revelador? Considere el uso de la inteligencia artificial en los deportes, en particular en el béisbol. Según un artículo en El guardiánLos sistemas de exploración automatizados en las Grandes Ligas de Béisbol (MLB) a menudo priorizan métricas que favorecen a los jugadores de orígenes socioeconómicos más altos, que con frecuencia son blancos.

Esto ha llevado a la exclusión de jugadores negros y latinos talentosos, muchos de los cuales provienen de entornos menos privilegiados con acceso limitado a recursos deportivos avanzados.

Aunque parezca lejano, es un ejemplo crucial para comprender cómo funciona el sesgo algorítmico. El algoritmo analiza los datos que recibe y toma decisiones basándose en ellos. El problema es que los datos distan mucho de ser neutrales.

El deporte refleja lo que ocurre en otras áreas, como la captación de talento corporativo, la aprobación de créditos financieros y las políticas públicas. ¿El denominador común? La IA predice el "potencial" o el "riesgo", pero a menudo excluye a quienes más necesitan oportunidades.

Explora cómo las métricas impulsadas por IA en el béisbol resaltan los sesgos sistémicos que afectan a los jugadores negros y latinos en la MLB:

IA generativa y sesgos visuales

Más allá de las predicciones, otra área que está ganando atención es la generación de imágenes mediante IA. Herramientas como DALL-E y MidJourney están revolucionando la forma en que creamos arte y visualizamos el mundo. Sin embargo, como lo destaca Exploradores de noticias científicasEstos sistemas también conllevan sesgos.

Por ejemplo, cuando se les pide generar imágenes de profesionales, muchos algoritmos asocian a los médicos con hombres blancos y a las enfermeras con mujeres.

De igual manera, las solicitudes de representación de "liderazgo" presentan predominantemente figuras masculinas. Estos detalles, aparentemente insignificantes, no son insignificantes: moldean nuestra percepción del mundo y refuerzan estereotipos visuales que influyen en todo, desde la confianza en las profesiones hasta la representación mediática.

Esta cuestión se vuelve especialmente preocupante en contextos de crisis. Las imágenes o representaciones visuales generadas por IA, impregnadas de sesgo, inciden directamente en la forma en que las personas y las organizaciones responden a los acontecimientos, perpetuando las desigualdades en momentos críticos.

¿Cómo corregir el rumbo? Soluciones al sesgo algorítmico

A pesar de los desafíos, existen maneras de combatir el sesgo algorítmico y convertir la inteligencia artificial en un aliado para un futuro más justo. Aquí hay algunas ideas basadas en los estudios que hemos analizado:

- Auditorías continuas:Como lo destaca Con cableEs fundamental revisar periódicamente los algoritmos para detectar sesgos. Esto implica no solo identificar errores obvios, sino también cuestionar las suposiciones implícitas en los datos.

- Equipos diversos: Universidad Chapman Destaca que los equipos diversos (en términos de raza, género y experiencia) son cruciales para detectar sesgos que podrían pasar desapercibidos en grupos homogéneos.

- Sistemas híbridos: Laboratorios InData sugiere que incluir a los humanos en el proceso de revisión es vital, especialmente para decisiones que involucran consideraciones éticas o culturales.

- Educación y ConcientizaciónParte del problema radica en que muchos desarrolladores y organizaciones aún no comprenden del todo el impacto del sesgo algorítmico. Las campañas de concienciación pueden ayudar a superar esta brecha.

- Transparencia:Las empresas que desarrollan IA deben ser más transparentes sobre cómo funcionan sus sistemas, qué datos utilizan y qué esfuerzos se están realizando para mitigar los sesgos.

Estas soluciones no sólo son prácticas, sino que también suponen un paso para garantizar que la IA sirva como fuerza para la equidad en lugar de un perpetuador de desigualdades.

Las organizaciones y el desafío del sesgo en la IA

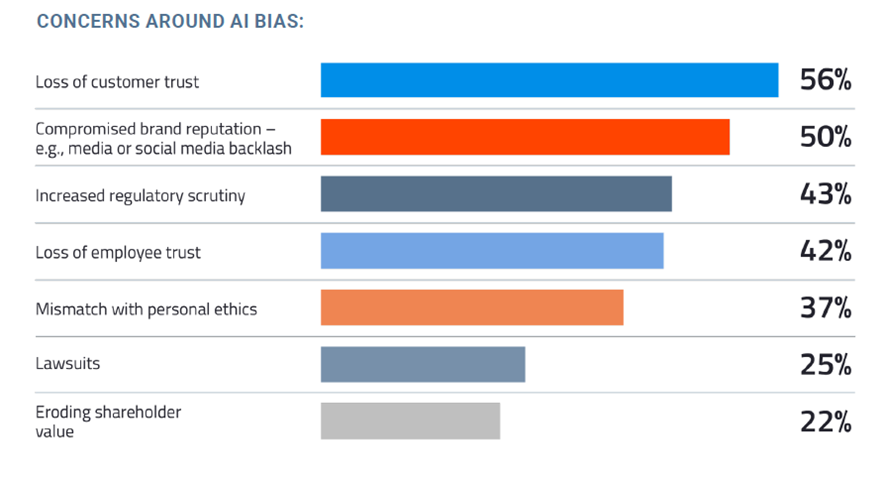

Un análisis realizado por... ofrece una visión reveladora de cómo las empresas están abordando el sesgo algorítmico. Datanami, destacando un paisaje preocupante.

El siguiente gráfico ilustra los principales desafíos que enfrentan las organizaciones para mitigar el sesgo en los sistemas de inteligencia artificial.

Los datos muestran que, si bien muchas empresas reconocen el problema, pocas cuentan con procesos efectivos para abordarlo. Las principales barreras incluyen la falta de transparencia, la capacitación insuficiente y los equipos homogéneos.

¿Qué nos dice esto? Ese sesgo algorítmico no es solo un problema técnico, sino también organizacional y estratégico. Para garantizar que la IA sea un aliado en lugar de un potenciador de las desigualdades, las empresas deben invertir en diversidad, formación y auditorías continuas.

El crecimiento del debate ético en la inteligencia artificial

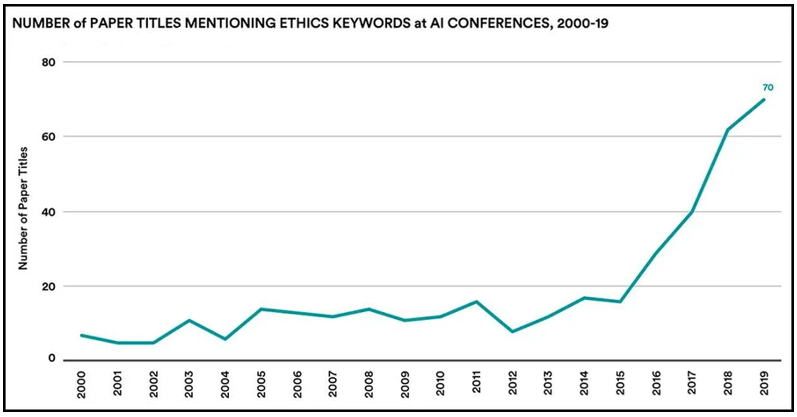

Aunque muchas empresas aún están rezagadas en materia de ética en IA, los investigadores han logrado avances significativos en este ámbito. El gráfico a continuación destaca el marcado aumento de artículos académicos relacionados con la ética de la IA presentados en congresos en los últimos años.

Esta es una señal positiva de que cuestiones como el sesgo algorítmico, la opacidad en la toma de decisiones y la privacidad están ganando más atención entre los expertos.

Como lo señaló Índice de IAEste creciente interés en los congresos indica que las futuras generaciones de profesionales se centrarán más en abordar estos desafíos éticos.

El informe enfatiza que los investigadores apenas están comenzando a desarrollar pruebas cuantitativas de sesgo en sistemas de IA. En otras palabras, si bien el progreso está en marcha, aún queda mucho trabajo por hacer para traducir la conciencia académica en soluciones prácticas y escalables.

¿Podemos crear una Inteligencia Artificial más justa?

Al final, el debate sobre la inteligencia artificial y el sesgo algorítmico no es sólo técnico: es profundamente humano.

Hablamos de cómo usamos la tecnología para dar forma al futuro y cómo garantizamos que sea inclusivo y justo para todos.

La buena noticia es que contamos con las herramientas y el conocimiento para solucionar estos problemas. ¿La mala? Requiere esfuerzo, compromiso y un cambio de mentalidad sobre lo que consideramos "normal" en la tecnología.

Si queremos usar la inteligencia artificial para predecir crisis de forma ética y eficaz, debemos asegurarnos de que no repita los errores del pasado. Al fin y al cabo, el futuro debería ser un lugar donde la innovación no implique exclusión y donde todos tengan la oportunidad de prosperar.